NEUSTART

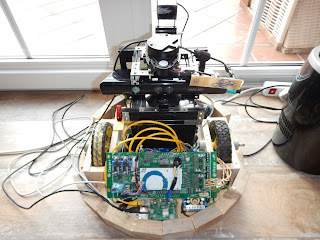

Moin zusammen, ich habe mich entschlossen, für die Programmierung in ROS 2, einen NEUSTART zu machen. Ich werde mich erstmal "erneut" durch eine Vielzahl von Tutorials und Trainings hangeln. Die Entscheidung, welche Art von Roboter es nun wird, ist letztendlich noch nicht entschieden! Zur Auswahl stehen mindestens die folgenden Typen: "Rasenmäher"-Plattform, mit Gehäuse wie der Dome vom R2-D2 Cobot-Arm, welcher z.B. mit einem Gripper versehen werden kann Falls von euch Vorschläge kommen, Nehme ich Feedback gerne auf.